Quand on entend parler de l’intelligence artificielle, on se dit qu’il faudrait avoir fait des études en robotique ou en informatique, ou encore une autre filière comme l’électronique, pour pouvoir comprendre les bases fondamentales de ce nouveau concept, très en vogue actuellement.

Il en est rien puisqu’aujourd’hui, il est mis à la disposition des professionnels, des logiciels permettant d’exploiter l’intelligence artificielle pour résoudre une problématique donnée. La démystification de ce concept a fait que maintenant, cet outil est utilisé sans grande difficulté et selon le besoin de l’utilisateur.

Pour simplifier, on dira que l’Intelligence artificielle sert à prédire le résultat d’un phénomène observé et cela grâce à l’utilisation d’un outil informatique (logiciel) qui bien entendu exploite des modèles mathématiques.

On parle donc de prédiction c’est-à-dire d’une réponse qui à priori est tributaire d’un certain nombre de facteurs. Posons-nous la question : Est-ce qu’on peut prévoir s’il va faire beau demain? Est-ce qu’on peut prévoir s’il va y avoir un effondrement du prix de pétrole ? etc…

Ce sont toutes des questions qui quelques fois ont des réponses avec bien entendu un risque d’erreur maitrisé. Le soir avant le journal télévisé, on s’informe de la météo du lendemain, quelques fois même de celle de la semaine suivante. Il est clair qu’un certain nombre de facteurs (vent, humidité, etc…) rassemblés dans des modèles mathématiques, validés expérimentalement peuvent servir d’outils de prédiction. Mais il ya tellement de facteurs avec des variations multilinéaires qu’il est quasi impossible de faire les calculs manuellement ; et c’est la raison pour laquelle on a recours à l’informatique, en fait pour accélérer les calculs et nous donner les tendances graphiquement.

Récemment j’ai lu une excellente publication d’une équipe de cardiologues algériens qui ont mis en place cet outil pour prédire le risque d’AVC sur les patients [1], ce qui démontre de la maitrise de cet outil dans le domaine de la santé.

Revenons maintenant à l’industrie pharmaceutique, la problématique étant claire : afin de produire un médicament de qualité, il faut parvenir à maitriser tous les paramètres du process. Parfois, une petite variation des conditions opératoires peut avoir des conséquences néfastes sur la qualité du produit et inversement. Alors il serait intéressant de développer le concept de l’interaction de la qualité du produit vis-à-vis du procédé via l’intelligence artificielle.

La base de l’intelligence de l’Homme est le fonctionnement harmonieux du cerveau qui est composé d’un réseau de neurones. Un neurone biologique est une cellule dont la principale fonction est la collecte, le traitement et la dissémination de signaux nerveux et la capacité de traitement de l’information du cerveau émane essentiellement de réseaux de tels neurones.

Chaque neurone, Figure 1 est constitué d’un corps contenant le noyau de la cellule. De la cellule émanent plusieurs fibres appelés dendrites et une seule longue fibre appelée axon.

Figure 1 : Neurone biologique

Un neurone fait des connexions avec d’autres neurones à des jonctions appelées synapes. Les signaux sont propagés d’un neurone à un autre par des réactions électrochimiques très complexes. Donc, les signaux contrôlent l’activité du cerveau et on pense que ces mécanismes constituent la base de l’apprentissage dans le cerveau [2].

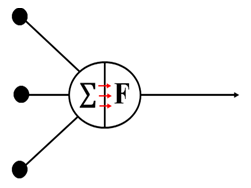

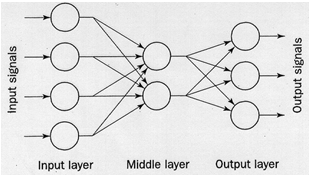

Faisons maintenant l’analogie entre le cerveau et un réseau de neurones artificiels. Un réseau de neurones est constitué processeurs élémentaires connectés par des liens directes, Figure 2.

Un processeur élémentaire qui est par analogie un neurone biologique possède cette capacité de recevoir via des liens des signaux de neurones en amont et à les propager une fois qu’il est activé.

Figure 2 : Réseau artificiel

Chaque lien a un poids qui sert à déterminer la force de la sortie associée dans la combinaison linéaire avec les autres signaux.

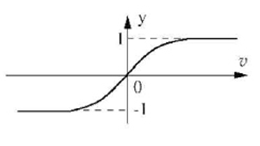

Le calcul dans chaque neurone se fait en parallèle avec les autres. Pour activer un neurone, on utilise des fonctions mathématiques complexes comme les fonctions sigmoïdes, Figure 3.

Figure 3 : Fonction sigmoide

L’architecture d’un réseau de neurones est assez classique ; elle est composée d’un nombre finis de processeurs élémentaires et des liens pondérés passant un signal d’un neurone à un autre.

Plusieurs signaux rentrent dans un neurone artificiel mais seule un signal en ressort. L’architecture est faite de sorte à avoir une couche d’entrée composée de plusieurs neurones, une à plusieurs couches intermédiaires qu’on appelle couches cachées et une couche de sortie, Figure 4.

Figure 4: Architecture d’un réseau de neurones

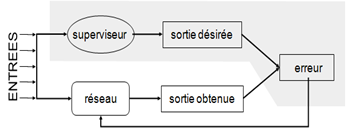

Afin d’utiliser l’Intelligence Artificielle, il est nécéssaire de créer une base de données en general à partir des valeurs expérimentales ou encore du vécu. Cette étape designée par phase d’apprentissage permet de créer l’algorithme d’apprentissage. Elle consiste à ajuster les poids du réseau de neurones, pour minimiser une certaine mesure d’erreur sur l’échantillon d’apprentissage. Ainsi, l’apprentissage est formulée comme une recherche optimale dans l’espace des poids!, Figure 5

Figure 5 : Schématisation de la phase d’apprentissage

La mesure de l’erreur est la somme des carrées des écarts qui est aussi utilisée comme pour la méthode des moindres carrées dans le cas de la régression linéaire.

On va ajuster les poids pour minimiser la somme des carrés des écarts entre les sorties observées et les sorties désirées. Grosso modo, ça y ressemble à l’expérience de Pavlov. En activant une sonnerie chaque fois que de la nourriture est présentée à un chien, le chien fini par associer la sonnerie à l’heure du repas. Une sorte d’apprentissage par conditionnement.

Une fois la phase d’apprentissage achevée et validée, l’algorithme est d’une puissance tel qu’il peut prédire des resultats d’expériences . Par exemple, L’établissement d’un réseau de neurones sur un procédé nous permettra de lier les réponses des attributs qualité du produit médicamenteux aux paramètres critiques du procédé. Ainsi, une déviation détectée aussi minime soit elle peut être corrigée par ajustement des paramètres process. Il représente un outil prédictif très puissant et aujourd’hui, il existe des logiciels sur le marché comme MATLAB dans ses dernières versions ou une rubrique dédiée aux réseaux de neurones y est consacrée.

Considérons l’application de cet outil à une étude réalisée en laboratoire. Il s’agit de la granulation en lit d’air fluidisé ; cette opération est importante car c’est une étape cruciale dans l’élaboration des formes sèches dans l’industrie pharmaceutique. Comparativement à la poudre, un grain présente des avantages indéniables dans sa manipulation. Ainsi, son écoulement est amélioré, sa cohésion en compression s’accroit, la friabilité et l’empoussièrement diminuent, formation d’un mélange homogène assurée et bien d’autres avantages [3].

L’opération en elle-même consiste à introduire la poudre pharmaceutique dans le compartiment cylindro conique de l’installation puis à faire subir un mouvement turbulent à cette poudre en faisant arriver de l’air à travers une zone d’expansion. Au cours de ce brassage, une solution liante est introduite par pulvérisation, ce qui engendre la formation de grains. Une fois le mouillage terminé, on procède à un séchage des grains jusqu’à obtenir une humidité résiduelle adéquate pour une compression.

On peut voir sur la figure 6 l’appareil utilisé et qui se trouve dans mon laboratoire. Les paramètres critiques d’une opération de granulation sont : le débit de fluidisation d’air, le débit de pulvérisation de la solution liante et la température de fluidisation. En fait ce sont les 3 paramètres les plus importants pour conduire une opération de granulation.

Figure 6 : Le Lit d’air fluidisé

Au cours du process, le champs de température à l’intérieur de l’équipement est une information capitale puisqu’elle conditionne la qualité du grain, à savoir ses propriétés physiques et rhéologiques (porosité, ditstribution granulométrique, écoulement,etc…).

D’ailleurs, des expériences ont été réalisées afin de montrer ce lien qui existe entre les réponses du système et le changement des conditions opératoires. Ces expériences vont être la base de l’apprentissage du réseau de neurones que nous avons construit.

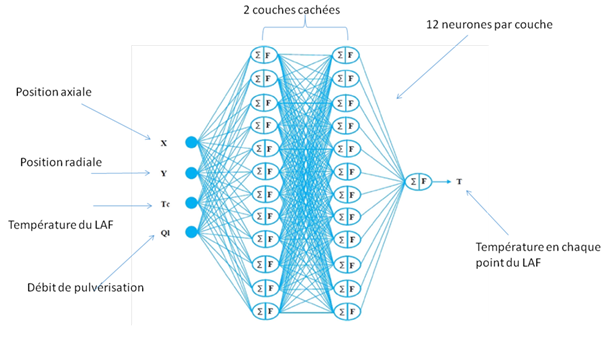

Voici en figure 7 l’architecture du réseau de neurones pour le lit fluidisé en étape de granulation. On a trouvé une erreur minimale lorsqu’on dispose 2 couches de 12 neurones cachées et en utilisant une fonction d’activation de type sigmoide non linéaire.

Figure 7 : Architecture du réseau de neurones

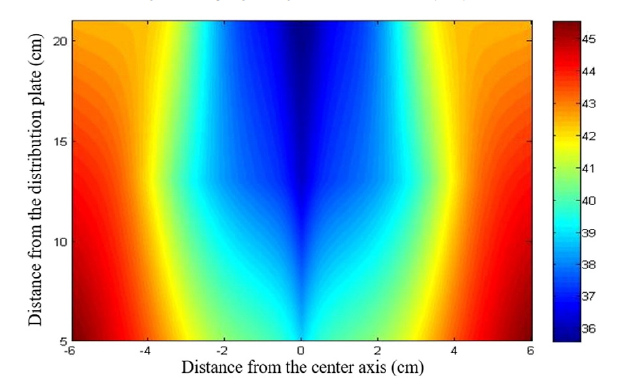

Je vous présente sur la figure 8, un profil de température obtenus à 21 cm de la base du lit. On observe un puits dans ce cas ce qui prouve que la profondeur de pénétration de la solution liante a un effet conséquent sur le champs de température [4].

Figure 8: Champs de temperature dans le lit fluidisé lors de la granulation

En conclusion, on peut affirmer que l’intelligence artificielle est un outil prédictif utile dans tous les domaines et particulièrement dans le domaine de la production de médicaments. Nous parlons beaucoup ces dernières années du concept de quality by design qui se traduit par une maitrise de la qualité du produit pharmaceutique tout au long son de son cycle de fabrication. Ainsi, dans les ICH Q8, ce concept a été lié au PAT (pharmaceutical analytical technology) qui permet de développer de nouvelles méthodes de détection des attributs qualité au fur et à mesure de la production du médicament et d’ajuster le procédé pour y remédier en cas de déviation. A travers cet exemple, nous voyons que l’intelligence artificielle basée sur les réseaux de neurones peut apporter des solutions à ce concept.

Bibliographie :

1- M. Raiah, M.F. Mesli, A. Abdelouahab, H.M. Ali Lahmar. «Aide à la décision par les réseaux de neurones artificiels : cas de l’infarctus du myocarde au service des urgences cardiologiques à Oran ». Journal Algérien des Sciences de la Santé. ATRSS, N°0, Janvier 2019

2-Mahdi Yassine, Kamel Daoud “Microdroplet Size Prediction in Microfluidic Systems via Artificial Neural Network Modelling for Water-In-oil Emulsion Formulation”, Journal of Dispersion Science and Technology, doi 10.1080/01932691.2016.1257391

3-Mahdi Yassine, Mouhi Lilia, Guemras Nadjet, Kamel Daoud “Coupling image analysis and the artificial neural networks to predict a mixing time of a pharmaceutical powder”.Journal of Fundamental and Applied Sciences Vol. 8, N°3, pp: 655-670. 2016, doi: 10.4314/jfas.v8i3.1.

4-Korteby Yasmine, Mahdi Yassine, Azizou Amel, Daoud Kamel , Geza Regdon Jr “Implementation of an artificial neural network as a PAT tool for the prediction of temperature distribution within a pharmaceutical fluidized bed granulator ”.European Journal of Pharmaceutical Sciences , Volume 88, Pages : 219-232. doi :10.1016/j.ejps.20